kunstig intelligens

Henger du med på AI-utviklingen? Her er de viktigste gjennombruddene nå

– Trenden ser ut til å ha akselerert i det siste, sier AI-ekspert Jakob Graabak. – Dette er kanskje den aller viktigste tekniske utviklingen som skjer akkurat nå, og den kommer i stor grad til å avgjøre hvor kraftig AI vi ser i løpet av de neste få årene.

Etter at de store språkmodellene (LLM) ble presentert for et globalt publikum høsten 2022 og alle kastet seg over generativ AI, må hypen sies å ha lagt seg noe.

Men Shifters gjennomgang av status på feltet viser at utviklingen i teknologien bare har akselerert siden det. Helt sentralt står AIs evne til å løse tidkrevende oppgaver.

Snakker høyere om AGI

Selv om det er bedre bildegenerering, og «Ghiblifisering» av bilder etter den japanske tegnefilmstudioet Ghibli, som engasjerer mest i sosiale medier, snakker AI-eksperter nå om at de aller beste modellene overgår de aller beste menneskene på stadig flere områder, såkalt artificial general intelligence (AGI).

Både OpenAIs o3 og Googles Gemini 2.5 Pro har overbevist domeneeksperter i alt fra medisin til økonomi om at AI vil kunne gi minst like gode svar som de smarteste forskerne på feltet allerede nå.

Hvorvidt det faktisk er AGI eller ikke, tones ned. Et problem er at man ikke har gode definisjoner på hva AGI er, ifølge AI-forsker Ethan Mollick som har lansert begrepet «jagged frontier» for hvordan AI-systemene har en ujevn horisont hvor de imponerer på noen områder og skuffer stort på andre.

Mens o3 klarte å lese et orienteringskart og legge opp den klart raskeste ruten, i vår test, klarte den ikke å løse årets påskekrim på melkekartongen da vi forsøkte det.

Blir bedre til tidkrevende oppgaver

Jakob Graabak er direktør for fremsikt (foresight) i den uavhengige europeiske tenketanken Centre for Future Generations. Han følger spesielt med på AI-systemenes evne til å løse tidkrevende oppgaver og viser til forskerkollektivet Metr som evaluerer AI-systemenes evne til å utføre komplekse oppgaver uten menneskelig innblanding. Gruppen er opptatt av ansvarlig utvikling og jobbet tidligere med både OpenAI og Anthropic om dette.

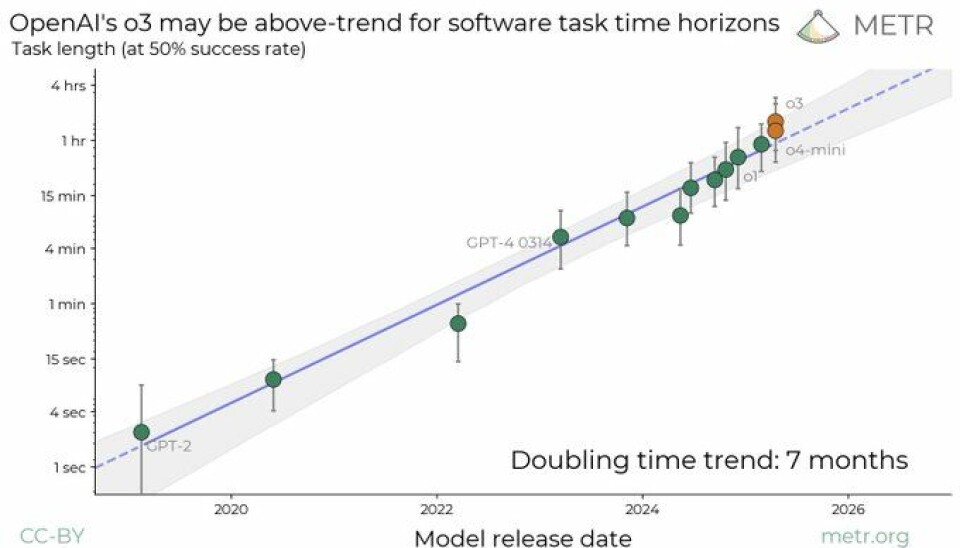

Ved å måle lengden på en oppgave, blir det tydelig at AIs evner fortsetter å vokse eksponentielt de siste seks årene. Nå i 2025 kan de beste modellene utføre oppgaver som ville tatt et menneske opp til en time. GPT-4, som kom i 2023, ble målt til å kunne ta over oppgaver som maks ville tatt 5 minutter.

Metr anslår at doblingstiden er på rundt 7 måneder nå, det betyr i så fall at man innen fem år vil se AI-agenter som helt uavhenging av mennesker kan utføre oppgaver som i dag tar arbeidstagere dager eller til og med uker å utføre.

– Trenden ser ut til å ha akselerert i det siste, sier Graabak. – Dette er kanskje den aller viktigste tekniske utviklingen som skjer akkurat nå, og den kommer i stor grad til å avgjøre hvor kraftig AI vi ser i løpet av de neste få årene.

Bak ligger stadig sterkere regnekraft.

– Den viktigste årsaken til at vi har fått kraftigere AI-modeller har vært at utviklerne har skalert opp regnekraften som brukes på å trene modellene. Fra 2010 til 2023 ble disse prosessene (såkalt «pre-trening») oppskalert 10 milliarder ganger, og trenden har fortsatt til nå: modellene som trenes i dag krever rundt 50x flere beregninger enn GPT-4 gjorde for et par år siden, sier Graabak og viser til at AI i samme periode har lært seg å løse mange nye oppgaver.

– Fellesnevneren for disse oppgavene er at vi har klart å sette opp automatiserte treningsprosesser hvor AIen kan eksperimentere med ulike løsninger og få feedback på hva som virker godt, og så gjøre mer av de tingene.

Samtidig er teknologien blitt mye billigere å bruke og oppskalere. Ifølge OpenAI er det i løpet av de siste 18 månedene blitt 100 ganger billigere å kjøre de kraftigste modellene.

Graabak peker på at dette i stor grad er drevet frem av såkalt destillering, altså at det er lettere å trene mindre og billigere modeller som etterlikner de store og kostbare når de store først er trent.

Overgangen til AI-agenter

AI-eksperten tror når vi står overfor et skift i utviklingen av disse modellene, fra store språkmodeller til agentiske modeller som kan resonnere og handle selv.

– Det er i ferd med å bli for kostbart og krevende å skalere «pre-trening» ytterligere. Samtidig har modeller som o1 og DeepSeek-R1 vist at det er mye å hente på god «post-trening» og resonnering i kontekst - altså at modellen har mulighet til å tenke seg om før den svarer, slik vi mennesker også gjør, sier han.

Fremover venter han at mange av de ledende utviklerne vil fokusere på å automatisere seg selv - å lage AI som kan lage enda smartere AI.

– For å lykkes med dette så må AIen være i stand til å håndtere komplekse programmeringsutfordringer. Ett mål på dette er «hvor lang tid tar det for en menneskelig programmerer å løse dette problemet».